Nvidia – Szuperprocesszor mesterséges intelligenciához

Akár tíz billió paramétert tartalmazó nagy nyelvi modellekre épülő generatív AI valós idejű futtatásához jelentett be új processzort és az eddiginél nagyságrenddel nagyobb teljesítményű rendszereket az Nvidia. A gyártó fejlesztői konferenciáján a hardvert kiegészítő mikroszolgáltatások és felhő-API-k is bemutatkoztak.

A kaliforniai San Joséban március második felében megtartott GTC 2024 konferencián premierező Nvidia Blackwell platformmal a szervezetek valós időben futtathatják a minden eddiginél nagyobb, több billió paramétert tartalmazó nagy nyelvi modellekre (LLM-ekre) épülő generatív mesterséges intelligenciát, az eddigiekhez képest akár 25-ször alacsonyabb költségek és energiafogyasztás mellett, mondta a világ harmadik legértékesebb vállalatának számító processzorgyártó.

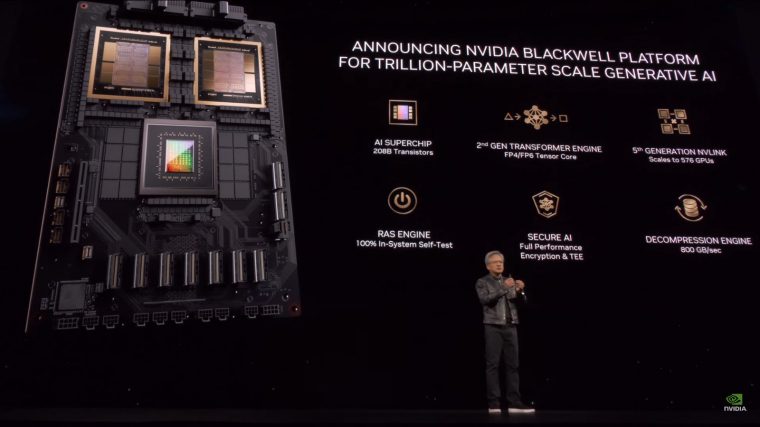

A Blackwell GPU architektúra ezt az Nvidia által korszakalkotónak nevezett teljesítménynövekedést hat átformáló erejű technológiával éri el. Együttesen ezek az újítások számos területen – közöttük az adatfeldolgozásban, a mérnöki szimulációk készítésében, az elektronikai tervezés automatizálásában, a gyógyszerkutatásban, a kvantum-számítástechnikában és a generatív AI alkalmazásában is – áttörést hozhatnak.

– Három évtizede a számítástechnika gyorsításán dolgozunk, hogy olyan transzformáló hatású technológiák fejlesztését tegyük lehetővé, mint a mélytanulás és a mesterséges intelligencia – mondta a konferencia nyitó előadásában Jensen Huang, az Nvidia alapító vezérigazgatója. – Korunk meghatározó technológiája a generatív mesterséges intelligencia, és a Blackwell hajtóerőt ad ehhez az új ipari forradalomhoz. A világ legdinamikusabb vállalataival együttműködve az AI ígéretét minden iparágban valóra fogjuk váltani.

Masszív szuperchip…

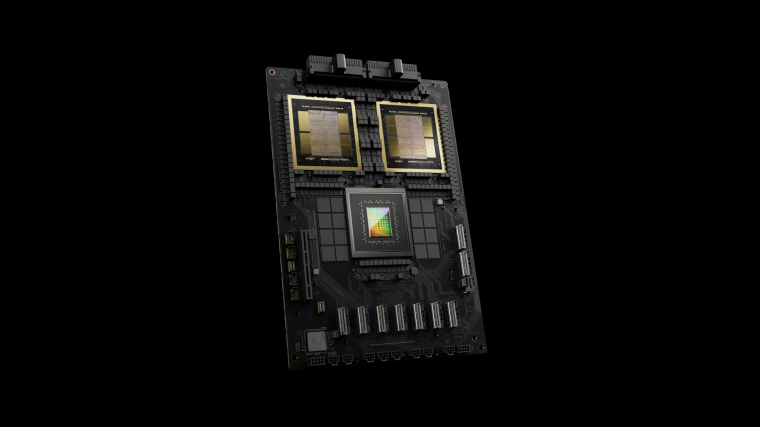

A Blackwell platform akár 10 billió paramétert tartalmazó LLM-ek tanítását és valós idejű következtetéseit – a tanított modell új adatokon történő, valós idejű használatát – lehetővé tevő, innovatív technológiái közül kiemelkedik a 208 milliárd tranzisztort tartalmazó grafikus processzor (GPU), amelyet két darab, másodpercenként 10 terabájt átviteli sebességű közvetlen (chip-to-chip) adatkapcsolaton kommunikáló szilíciumlapka alkot.

A platform kiugróan nagy teljesítményét fokozza több más – skálázhatóságot, megbízhatóságot, rendelkezésre állást és biztonságot növelő, valamint különféle titkosítási protokollokat és adatformátumokat támogató – újítás mellett az Nvidia processzorokat összekapcsoló interconnect technológiájának ötödik generációja is. Az NVLink legfrissebb nemzedéke 1,8 terabájt/másodperc kétirányú átviteli sebességet biztosít grafikus processzoronként, és akár 576 darab GPU között is zökkenőmentes kommunikációt tesz lehetővé a legösszetettebb LLM-ek támogatásához.

A GTC konferencián mutatkozott be az Nvidia GB200 Grace Blackwell Superchip is, amely két darab Nvidia B200 Tensor Core GPU-t kapcsol össze egy Nvidia Grace CPU-val 900 gigabájt/másodperc átviteli sebességű és rendkívül alacsony energiafogyasztású NVLink chip-to-chip interconnecten keresztül. A lehető legnagyobb AI teljesítmény eléréséhez a GB200 alapú rendszerek az Nvidia szintén továbbfejlesztett Quantum-X800 InfiniBand és Spectrum-X800 Ethernet platformjaival is összekapcsolhatók akár 800 gigabájt/másodperc hálózati átviteli sebesség mellett.

Kulcsfontosságú komponens a szuperprocesszor az Nvidia GB200 NVL72 multi-node felépítésű, folyadékhűtéses, rack szekrénybe szerelt rendszerében is, amelyet a gyártó a leginkább számításigényes munkaterhelések támogatására készített fel. Az új rendszer akár 36 darab Grace Blackwell Superchippel – bennük 72 Blackwell GPU-val és 36 Grace CPU-val – konfigurálható, és tartalmazza az Nvidia BlueField-3 adatfeldolgozó egységét (DPU-ját) is, amellyel a hálózatok gyorsítását, az összeállítható tárolók használatát, a zero-trust biztonságot és a grafikus processzorokra épülő feldolgozás elasztikusságát támogatja a hiperskálázott AI felhőkben. A GB200 NVL72 az azonos számú H100 Tensor Core GPU-t tartalmazó rendszerekkel összevetve akár 3-szor nagyobb teljesítményt ad az LLM-ek inferencia munkaterheléseihez, miközben akár 25-ször kevesebb energiát fogyaszt, így a költségeket is hasonló arányban csökkenti, mondta az Nvidia.

…és újgenerációs AI szuperszámítógép

San Joséban debütált az Nvidia DGX SuperPOD, a gyártó újgenerációs AI szuperszámítógépe, amely az ultranagy modellek és a szuperskálázott munkaterhelések futtatásához megfelelő feldolgozási teljesítményt és folyamatos rendelkezésre állást biztosít. Az új, rendkívül hatékony, folyadékhűtéses és rack-skálázott architektúrára épülő DGX SuperPOD alapja az Nvidia DGX GB200-as rendszer, amely a GB200 NVL72-höz hasonlóan 36 darab Grace Blackwell Superchipet tartalmaz, és (FP4-es precíziós érték mellett) 11,5 exaflops számítási teljesítményt, valamint 240 terabájt méretű gyors memóriát ad az AI munkaterhelések futtatásához, és erőforrásait a vállalatok további rack szekrények hozzáadásával skálázhatják.

A DGX SuperPOD nyolc darab vagy annál több DGX GB200 rendszerrel konfigurálható, így több tízezer darab GB200 Superchipig méretezhető, amelyeket az Nvidia Quantum InfiniBand kapcsol össze. Az újgenerációs AI modellekhez szükséges, masszív, megosztott memóriatér kialakításához a gyártó nyolc DGX GB200 rendszerből kialakított konfigurációt ajánl a szervezeteknek, amelyben az NVLink kapcsol össze 576 darab Blackwell grafikus processzort.

A DGX SuperPOD számítási szövete emellett tartalmazza az említett BlueField-3 DPU-kat, valamint az Nvidia Scalable Hierarchical Aggregation and Reduction Protocol (SHARP) technológiájának negyedik nemzedékét is. Utóbbi 14,4 teraflops hálózaton belüli számítási teljesítmény elérését teszi lehetővé, ami az architektúra korábbi generációjához képest négyszeres növekedésnek felel meg. Az új DGX SuperPOD így komplett, adatközpont-méretű AI szuperszámítógépként jelenik meg, amely az Nvidia tanúsított partnerei által szállított, nagy teljesítményű tárolókkal érkezik. Megoldásaikat a szállítók gyárilag beépítik és tesztelik, az AI szuperszámítógépek így rendkívül gyorsan telepíthetők a vállalati adatközpontokban, mondta a processzorgyártó.

Konferenciáján az Nvidia bejelentette DGX B200-as rendszerének hatodik nemzedékét is, amelyet a szervezetek világszerte használnak AI modelljeik tanításához, finomhangolásához és futtatásához. Előző generációjával összevetve az egységes AI szuperszámítógépes platform most 15-ször nagyobb teljesítményt ér el a billió paraméteres modellek valós idejű inferencia számításaiban.

Mikroszolgáltatások és felhő-API-k

A gyártó minden DGX platformja tartalmazza az Nvidia AI Enterprise szoftverplatformját, amely többek között előre tanított alapmodellekkel, keretrendszerekkel és eszközkészletekkel segíti a vállalati szintű telepítést és fejlesztést. Az AI Enterprise platformra épülnek a szintén most bejelentett Nvidia NIM mikroszolgáltatások is, amelyekkel a szervezetek két tucatnál több alapmodellt taníthatnak saját adataikon, és teljesítményre optimalizált AI alkalmazásaik gyors bevezetéséhez bárhol futtatható, kész konténereket is kapnak.

San Joséban jelentette be az Nvidia öt új Omniverse Cloud alkalmazásprogramozási interfészét (API-ját) is. Segítségükkel a fejlesztők az Omniverse technológiákat közvetlenül a meglévő mérnöki tervező és ipari automatizációs szoftveralkalmazásaikkal integrálhatják, ezáltal digitális ikreket hozhatnak létre, amelyeken termékeiket, munkafolyamataikat és önvezérlésű gépeiket szimulálhatják, tesztelhetik és optimalizálhatják. Az Omniverse Cloud API-kat az ipari szoftverek legnagyobb szállítói – közöttük az Ansys, a Cadence, a Dassault Systèmes, a Hexagon, a Microsoft, a Rockwell Automation, a Siemens és a Trimble – építik be portfóliójukba.

Az Nvidia Blackwell architektúrára épülő termékek példányai az év hátralevő részében az AWS, az IBM Cloud, a Google Cloud, a Microsoft Azure és az Oracle Cloud Infrastructure felhőszolgáltatásai között, valamint olyan platformokon is meg fognak jelenni, mint az Oracle európai uniós szuverén felhője. Ugyancsak várható, hogy a DGX SuperPOD a DGX GB200 és DGX B200 rendszerekkel együtt már idén elérhetővé válik az Nvidia globális partnerein keresztül.

ComputerWorld.hu